Что такое дубли страниц?

Дубли — страницы с разными адресами, где полностью или частично совпадает контент. Любите разгадывать ребусы? Внимательно посмотрите на эту картинку и подумайте, какое из этих трех изображений наиболее соответствует запросу: «зеленая груша»? Сложно ответить, не так ли? Да, потому что все три груши одинаково зеленые, а выбрать нужно только одну, которая наиболее релевантна условиям поиска. Дилемма? В точно такой же непростой ситуации находятся и поисковики в случае обнаружения дублей. Они недоумевают, какую страницу нужно показать в поиске в ответ на запрос пользователя. Бывает, что поисковик считает главной страницей именно дубль, в результате в индекс не попадает ни одна, и сайт стремительно теряет свои позиции.

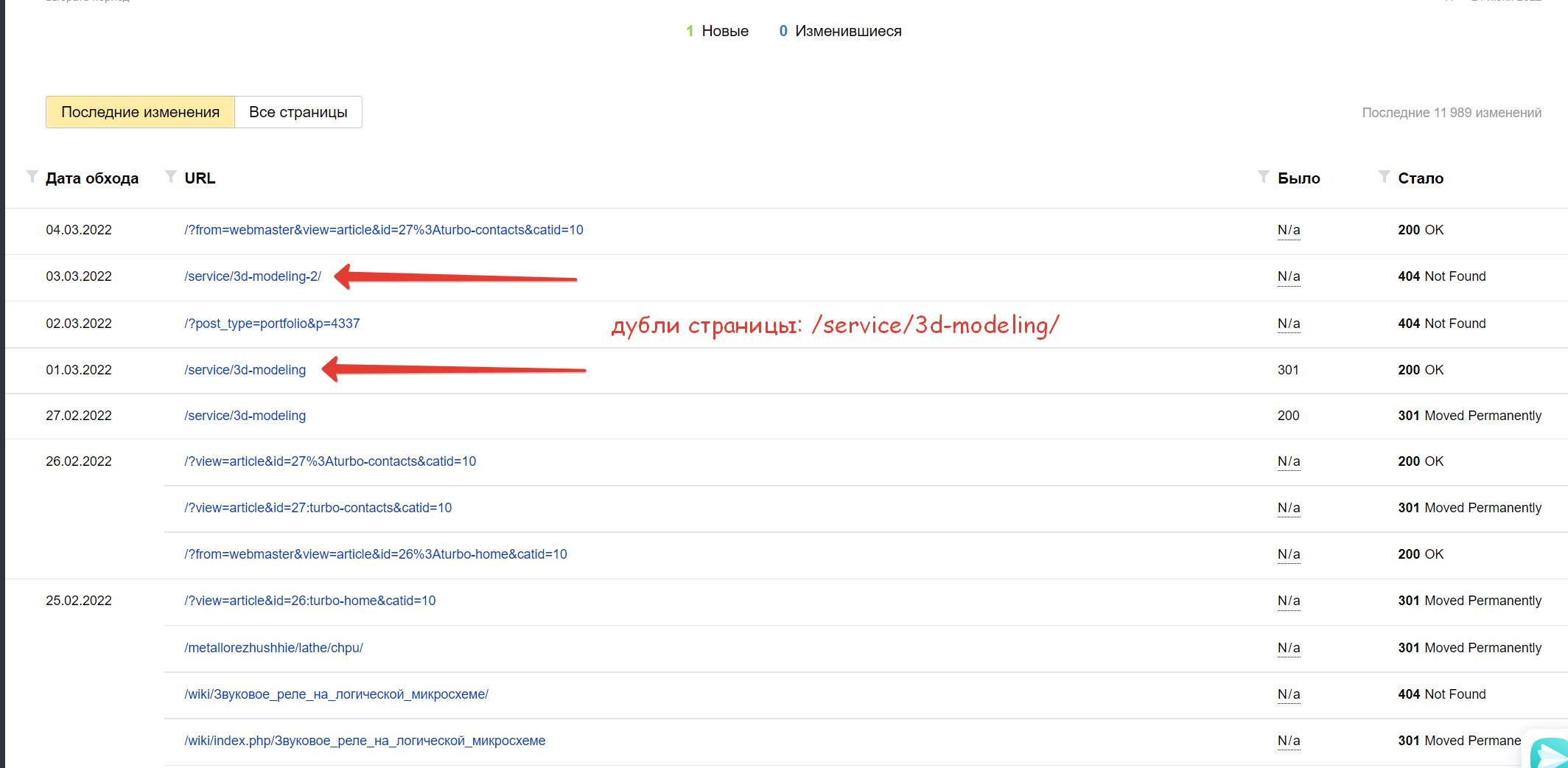

Определенные дубли страниц в вебмастером Яндекс

Зачем нужно удалять дубли страниц?

Каждый SEO специалист знает, что наличие дублей очень опасно для SEO. Пользователям они не мешают получить необходимую информацию. Копия страницы сайта очень серьезно воспринимается поисковиками и может в критических ситуациях привести к наложению санкций со стороны Яндекса и Google. Поэтому важно вовремя найти все дубли страниц и обезвредить их.

Как дубли страниц влияют на Яндекс?

В первую очередь произойдет снижение позиций в поиске по отдельным ключевым фразам. Сначала они начнут просто скакать из — за постоянной смены привязки ключа к релевантной странице, а потом поисковик существенно понизит сайт в ранжировании. Вот с этого момента можно включать режим SOS и оперативно исправлять ситуацию.

Какими бывают дубли страниц?

Специалисты поисковой оптимизации различают дубли страниц двух типов — полные или частичные.

Первые — когда две или более страницы содержат одинаковый контент.

Вторые — когда какая-то часть контента дублируется на нескольких страницах. Такое часто происходит, когда, например, копирайтеры берут кусок из одной статьи и вставляют его в другую.

Что такое полные дубли страниц и как они появляются?

- Когда создаются адреса с «www» и без «www»:http://site.ru/about

http://www.site.ru/about - Адреса со слешами и без нихhttp://site.ru/seo///top3

http://site.ru/seo/top3 - Адреса с HTTP и HTTPShttp://site.ru/seo

https://site.ru/seo - Создать дубли могут и реферальные ссылки. Как правило, реферальная ссылка имеет после знака «?» хвостик, начинающийся с «ref=…». Когда поcетитель переходит по ссылке с такой меткой, ему должна открываться обычная ссылка. Но часто оптимизаторы и веб — разработчики просто забывают убрать параметр «ref=…» и получают дубли.

- Дубли страниц могут появляться в результате неправильной настройки страницы с 404 — ошибкой.

- Некоторые страницы с utm — меткой или гет — параметрами «gclid», необходимыми для отслеживания рекламного трафика, часто попадают в индекс поисковиков и тоже являются дублями.http://site.ru/?utm_source=yandex&utm_medium=cpc&utm_campaign=sale

http://site.ru - Страницы с прописными и строчными буквами в urlhttp://site.ru/seo

http://site.ru/SEO - Приписка цифр в строку URLhttp://site.ru/seo123

http://site.ru/seo123/999

Такая ситуация часто случается на страницах сайтов на основе cамой популярной системы управления контентом — WordPress.

Как мы уже говорили выше, поисковики очень не любят наличие такой критичной ошибки как дубли страниц. За это Яндекс и Google могут применить карательные санкции — наложить на сайт фильтр или опустить в позициях. Полные дубли обнаружить гораздо проще, но вот проблем они могут принести из-за своего масштаба очень много.

Откуда берутся частичные дубликаты страниц?

В отличие от первого варианта, в этом случае диагностировать ошибку гораздо труднее. Немало неудобств доставляет и процедура самого избавления от частичных дублей. Частичные дубли подразумевают под собой дублирования части контента на нескольких страницах.

- Очень часто можно встретить частичные дубли на страницах листинга (ссылочного блока, при помощи которого на странице отдельная часть информации из общего массива данных), фильтров, различных сортировок. В этом случае на всех страницах присутствуют куски одного и того же контента, меняется только порядок и структура их размещения.

- Частичные дубли также могут появляться в описании товаров в карточках и каталоге. Чтобы исключить такую ошибку, нужно не выводить полную информацию о товаре в каталоге, либо написать уникальный текст, который не будет перекликаться с описанием в самой карточке товара. Но оптимизаторы часто пытаются сэкономить на копирайтинге, что выливается потом в серьезные проблемы с индексацией ссылок в поиске.

- Страницы скачивания и печати могут дублироваться с основной страницей.Например:

http://site.ru/seo

https://site.ru/seo/print

В отличие от полных дублей, частичные не сразу сказываются потерями в позициях сайта, они потихоньку будут подтачивать камень водой, делая жизнь оптимизатора все невыносимее.

Как найти дубли страниц на сайте?

Первый способ — при помощи оператора «site», вы просто вводите в Яндекс или Google оператора и название сайта:

site:wts.ru

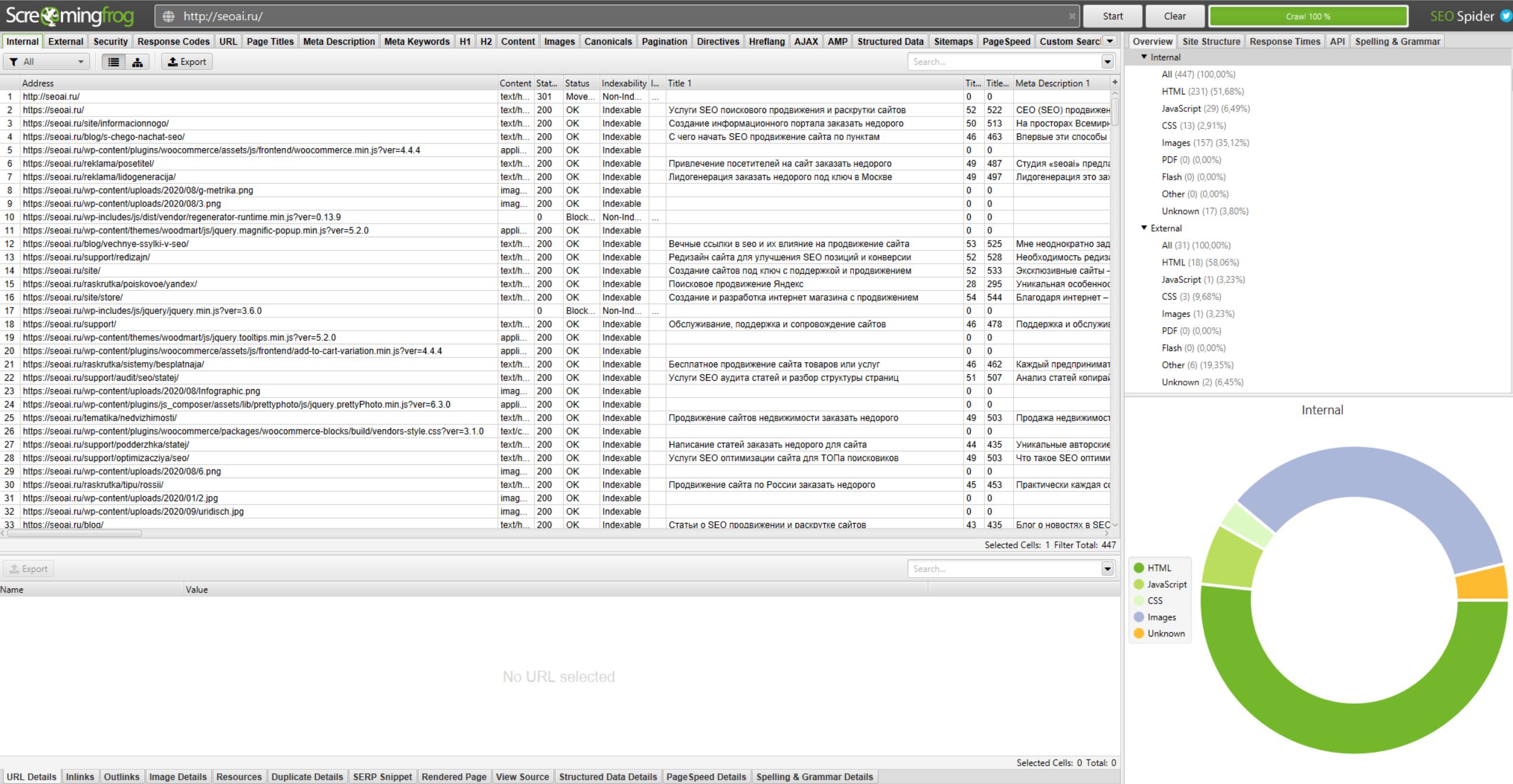

Второй способ — специальные сервисы или парсеры, которые могут обнаружить наличие дублей на сайте. К таким программам можно отнести — ComparseR 1.0.129, Xenu, WildShark SEO Spider, британский парсер Frog Seo Spider, Majento SiteAnalayzer 1.4.4.91, Serpstat.Многие из них бесплатные.

Механизм работы парсеров очень прост: программа запускает бота на сайт, анализирует и определяет список урлов с возможными совпадениями. Таким образом поиск дублей страниц сайта не занимает много времени, достаточно просто ввести в строку параметры сайта и ждать результата.

Интерфейс программы для сканирования сайта

Третий способ — потенциальные дубли может определить инструмент для веб — мастеров Google Search Console. Для этого его нужно открыть, зайти во вкладку «Оптимизация HTML» и проанализировать все страницы, на которых повторяется описание.

Четвертый способ — ручной. Опытные оптимизаторы и разработчики могут вручную просканировать дубли страниц в местах сайта, которые кажутся им проблемными.

Как удалить дубли страниц на сайте?

Не обладая специальными навыками и опытом, избавиться от дублей собственными силами будет очень трудно. Нужно будет самому изучить основы веб — разработки, различные коды программирования, азы seo — оптимизации. На это могут уйти несколько месяцев, а позиции сайта будут опускаться в выдаче. Лучше обратиться к профессионалам, которые оперативно удалят дубли и сделают специальные настройки:

- Запретят индексацию дублей в специальном текстовом файле в «robots.txt»

- В файле — конфигураторе добавят 301 редирект. Этот способ является основным при искоренении ошибки. Редирект нужен для автоматической переадресации с одного урл на другой.

- Для устранения дублей при выводе на печать и скачивании добавят тег meta name=»robots» content=»noindex, nofollow»

Иногда решение проблемы может заключаться в настройке самого движка, поэтому первоочередной задачей специалистов является выявление дублей, а уже потом их оперативное устранение. Дело в том, что для создания контента могут одновременно использоваться разные движки сайта (opencart, joomla, wordpress, bitrix). Например, главная структура сайта будет сделана на опенкарт, а блог на вордпресс. Естественно, что дубли на этих двух сайтах тоже будет сильно отличаться друг от друга.

Что такое битые ссылки?

Битыми ссылками называют такие URL, которые ведут пользователей на несуществующие страницы. Несуществующие страницы могут появляться в случае когда сайт был удален, страница поменяла адрес, случайно удалили страницу, на которую ссылаются, а также в результате сбоя при автоматическом обновлении данных. Когда робот находит в поиске такие ссылки, он переходит по ней и видит 404 ошибку, из- за чего на сайт может быть поставлен штамп низкокачественного ресурса. Что нужно сделать в этом случае?

- Удалить ссылки, которые направляют пользователей на несуществующие страницы

- Можно заполнить страницу полезным и интересным контентом

- Если обновили систему, то нужно сделать редирект 301

Что нужно усвоить из этой статьи?

- Дубли — это страницы, на которых возможно полное или частичное повторение контента.

- Основными причинами возникновения ошибки являются ошибки разработчиков и оптимизаторов, ошибки в самом движке, автоматическая генерация.

- Дубли очень негативно сказываются на SEO — индексация ухудшается, позиции в поиске понижаются, возможны санкции со стороны поисковиков.

- Обнаружить дубли могут помочь специальные сервиcы, Гугл Консоль, оператор site.

- Чтобы удалить дубли, нужно воспользоваться специальными тегами, а лучше всего доверить эту работу профессионалам.