Привет читателям поэтапного руководства заработка в интернете SeoAI.ru. Мы завершили основную часть установки настройки WordPress движка, установили самые необходимые плагины. До момента, когда мы напишем первую статью осталось совсем немного. Сегодня нам надо понять, что такое индексация сайта, какие файлы влияют на индексацию, от чего зависит индексация и как ее улучшить. Узнаем как запретить индексацию сайта в файле robots txt.

Содержание

- Понятие индексации и важность ее для нашего сайта

- Санкции при не правильном robots.txt

- Правильный файл robots.txt на WordPress, мета тег robots

Начну с основ. Чтобы поисковая система видела наш сайт и могла отобразить его в поиске, необходимо посещение поискового робота компании, в которую мы хотим добавить свой сайт.

Понятие индексации и важность её для сайта

Помимо посещения нашего ресурса, робот должен проиндексировать наш сайт, страницы, записи и так далее. Индексация сайта — это процесс добавления всех материалов в поиск яндекса, гугла и других поисковых компаний. Есть два способа, когда робот может найти ваш сайт и в дальнейшем его проиндексировать:

- Когда вы добавляете свой сайт через аддурилку поисковой системы или регистрируетесь там;

- Робот может перейти по ссылке на ваш сайт с другого проиндексированного сайта.

В начале развития любого проекта необходимо добиться максимальной индексации своего сайта, обратите внимание что это очень важно, и чем больше будет проиндексировано страниц, тем больший будет заработок у вас. Думайте и действуйте опережая свои шаги.

Яндекс дает определение робота : программа которая собирает и хранит адреса на страницы сайта, а также определяет и запоминает документ.

Когда робот анализирует документ и находит новую ссылку он запоминает ее и переходя по этой ссылке, индексирует все больше и больше страниц. Индексация понятие постоянное.

Внутренняя перелинковка, о которой мы говорили на прошлых уроках, помогает более качественно производить индексацию сайта. В Yandex анонсировано 11 поисковых роботов. Каждый выполняет свою функцию и один робот может индексировать картинки , ну а другой статьи.

От индексации страниц сайта будет зависеть и количество пользователей пришедших на блог, ведь чем больше страниц в индексе, тем больше пользователей вы получите. А чтобы проверить индексацию необходимо произвести следующие действия

- Добавить адрес страницы в поисковик, если результат будет найден (страница будет отображаться в поиске), значит она находится в индексе;

- Использование различных программ по проверке индексации;

- Проверка индексации с помощью различных онлайн сервисов, например РДС Бар.

Управлять индексацией совсем не сложно, главное научиться делать это правильно и своевременно. В нашем распоряжении есть 2 способа управления индексации сайта и страниц. Первый способ файл карты сайта, о которой мы уже говорили и довольно подробно разобрали в прошлых уроках.

Вторым способом управления индексацией является файл Robots.txt, который позволяет произвести запрет индексации, путем закрытия от индекса дублей, страниц, архивов, мета тегов и так далее. В принципе если необходимо, можно закрыть от индексации и весь сайт полностью.

Из своего опыта могу сказать что большинство новичков совсем не знают про Robots.txt или знают, но неправильно составляют Robots.txt для WordPress или любой другой CMS. Неправильное заполнение файла Роботс или полное его отсутствие, может быть одним из оснований попадания сайта под санкции, а уж спросите у любого вебмастера, который зарабатывает в интернете, что бан сайта в поисковой системе равно уменьшению своего дохода до нуля.

В свое время я тоже много не знал, да и сейчас постоянно само совершенствуюсь, так как бизнес в интернете это постоянное движение и слежение за новыми технологиями и различными информационными революциями.

Санкции при не правильном ROBOTS.TXT

Постараюсь объяснить, почему возможны санкции со стороны поисковиков при неверно заполненном файле Роботс. Есть такая штука как дубли страниц, это когда на 1 страницу мы можем попасть с различных мест, и адреса у них будут разные. Так вот если сделать запрет на индексации таких вот неприятных мест, с помощью которых, по разным адресам можно попасть на одну и туже страницу, то будет нам счастье и поисковики не применят к нам санкции, по крайней мере надеемся на это, в противном случае новичка будут ждать большие проблемы.

Помимо этого хорошим вариантом будет запрет индексации страниц не имеющих отношения к содержимому сайта. Также при борьбе с дублями имеет смысл сделать 301 редирект.

Robots.txt это обыкновенный текстовый файл, в котором прописываются указания для роботов, прежде чем начать индексировать сайт, робот обязательно прочитает указания в файле Роботс. Создать этот файл можно в любом текстовом редакторе, но следует помнить что название файла должно содержать только маленькие буквы, без заглавных, а также находится он должен в корневой папке каталога, ваш сайт://robots.txt именно тут и в таком формате.

Хочется отметить также, что анализ Роботс поисковая система Yandex может и не производить, вернее производить то будет, но написанные там команды не будут являться обязательными к исполнению.

Почему так? Ну так сказал яндекс, жираф большой, ему виднее. Но я еще ни разу не видел чтобы у кого то Robots.txt правильно настроенный не играл роли, в любом случае робот обращает на него внимание, и яндексоиды маленько лукавят.

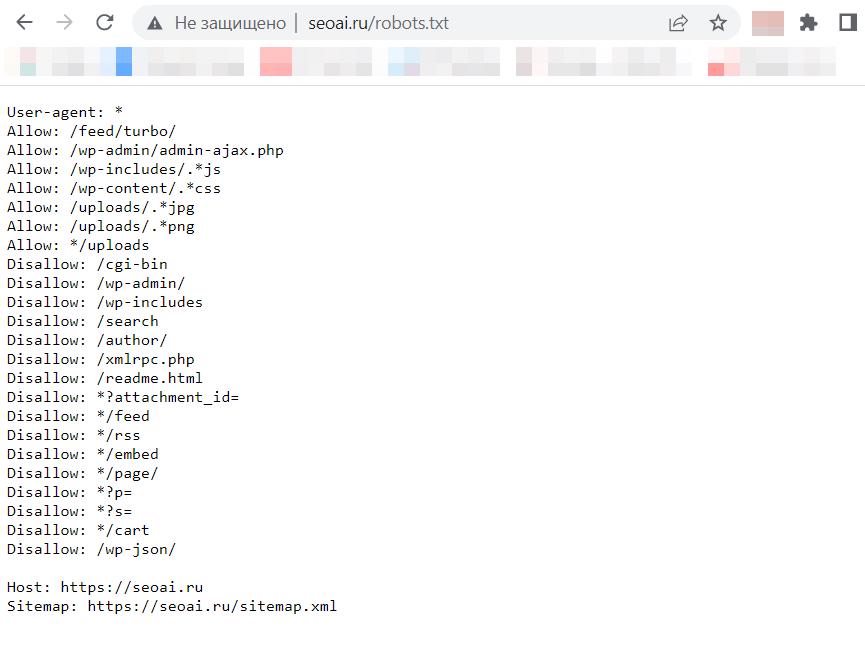

Внешний вид файла robots.txt

Выше на рисунке показан мой Robots.txt Примите к сведению, что на каждый движок надо прописывать свой Robots.txt, так как директории будут разными. В файле robots.txt есть директивы которые могут отличаться.

Правда есть и одинаковые для любого правильно созданного Robots.txt директивы. Например: User-Agent и Disallow. Одинаковыми будут только названия директив, значения которые идут после двоеточия могут существенно отличаться.

В первом случае указывается поисковик которому следует выполнять прописанные команды в файле Роботс. Если мы поставим * в этом пункте, то команды будут доступны для выполнения всеми поисковиками.

Если вы там укажете Yandex, то только эта поисковая машина будет обрабатывать указанные команды. Disallow Robots.txt это запрещающая директива, которая позволяет дать команду роботу не индексировать страницу, статью и так далее.

Правильный файл ROBOTS.TXT на WORDPRESS, мета тег ROBOTS

Если вы не знаете точно, что указать в файле Robots.txt , то можете скопировать пример по приведенному ниже коду.

Если у вас WordPress, то смело берите выше приведенный код моего файла Роботс. Если есть желание, то можете скачать Роботс у более продвинутых ресурсов. Директива Host показывает основной путь к вашему сайту, главное зеркало, указывается отдельным блоком для Яндекса, как видно на рисунке выше. Не забудьте изменить хост сата в файле на свой сайт.

Если необходимо закрыть несколько станиц, то для каждой придется прописывать свой адрес в файле Robots.txt. Думаю я ответил на ваши вопросы, как сделать и как проверить файл Роботс. Если вы считаете, что все таки информации недостаточно, задавайте вопросы в комментариях. На этом замечательный урок об индексации сайта и файле Robots.txt завершен. Удачного дня!)